想象一下,你在一个巨大的图书馆里查找一本非常冷门的书,这个图书馆就是你的主存储器(比如电脑的内存条),书就是你需要的数据,如果每次找书你都从最庞大的总书库(比如硬盘)开始找,那会非常慢,聪明的做法是,你先去一个小型的、常用的热门书籍阅览室(这就是缓存)看看,如果没有,再去更大的分区找,最后才去总书库。

三级缓存就是把这种“由近及远、由快到慢”的查找思想,应用到计算机数据处理中,它不是一个单一的技术,而是一套精心设计的层级策略,目的是让最常用的数据以最快的速度被获取到,从而极大地提升整个系统的效率。

第一级缓存:贴身侍卫

这是最快也是最小的缓存,通常直接集成在处理器芯片内部,你可以把它想象成你的工作台桌面,上面只放着当前正在阅读和马上要用的几本书(数据),它的速度极快,几乎和CPU的运算速度同步,容量很小,但命中率(也就是找到想要数据的概率)极高,因为CPU会智能地预测下一步可能需要什么数据,提前从二级缓存拿到这里,这一级缓存的核心策略是“极速响应”,牺牲容量来换取无与伦比的速度。

第二级缓存:专用书房

如果工作台桌面(一级缓存)上没有你要的书,你会转身到身后的一个专用书架上找,这个书架就是二级缓存,它比一级缓存大一些,速度稍慢一些,但依然在CPU芯片内部或非常靠近CPU的位置,这里存放着近期使用过、或者根据算法预测即将用到的数据,它是“一级缓存”和更慢的“三级缓存”之间的一个缓冲地带,策略是“容量与速度的平衡”,既保证了一定的存储量,又保持了较高的访问速度,确保CPU在大部分时间不至于“饿着”等数据。

第三级缓存:共享资源库

当你工作台和专用书架上都找不到书时,你就需要去一个更大的、为整个办公室(多个CPU核心)服务的共享图书室了,这就是三级缓存,它比二级缓存大得多,是所有CPU核心共享的,它的速度虽然比内存还是要快,但已经明显慢于一级和二级缓存,它的关键策略是“共享与协作”,在多核心处理器的今天,多个任务可能都需要同一份数据,三级缓存避免了每个核心都去遥远的内存里取同一份数据,而是让它们在这个“共享资源库”里快速共享,极大地减少了内存访问的压力和延迟。

三级缓存协同工作的精妙之处

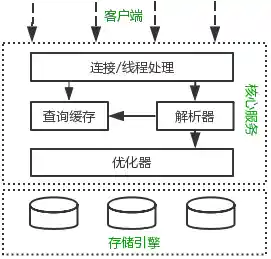

这三级缓存并非孤立工作,而是一个高效协同的流水线,当CPU需要数据时,它首先在一级缓存里找(L1 Lookup),如果找到(命中),皆大欢喜,如果没找到(未命中),则去二级缓存找(L2 Lookup),命中则将数据同时送入一级缓存以备下次快速访问,如果二级缓存也未命中,则查询三级缓存(L3 Lookup),如果三级缓存命中,数据会被送入二级和一级缓存,如果连三级缓存都未命中,那才不得不去速度最慢的主内存(DRAM)中读取,读取到的数据会依次填充到三级、二级和一级缓存中。

这个过程中,还有一个关键的策略叫“缓存一致性”,想象一下,如果办公室两个人同时在共享图书室和自己的工作台上修改同一本书的不同副本,就会造成数据混乱,缓存一致性协议(如MESI)就是确保所有级别的缓存中的数据副本都是最新的、一致的,当一个核心修改了数据,其他核心缓存中的旧副本会被标记为无效或更新。

为什么这是关键策略?

三级缓存技术之所以是关键策略,是因为它精准地解决了计算机系统中最主要的性能瓶颈——“内存墙”,即CPU速度远远快于内存速度,通过建立多级缓存,系统实现了:

三级缓存不是简单的数据副本存放,而是一套深刻理解数据访问局部性原理(时间局部性和空间局部性)的智能预测和调度系统,它通过精细的分工和协同,将昂贵的高速存储资源和廉价的大容量存储资源完美结合,以最低的成本实现了数据处理流程的最大化加速,是现代计算性能不可或缺的基石策略。