在我们开始聊16进制转换的技巧之前,我们先得明白,为什么在编程这个世界里,我们放着熟悉的10进制不用,非要跟16进制打交道?这就像我们平时用十进制数东西很顺手,但在某些特定场合,比如看时钟,我们会觉得用60进制(分秒)更方便,编程里的16进制也是这个道理,它是一种更适合计算机“思维”的计数方式,能让我们和机器更高效地沟通。

计算机最底层处理的是二进制,全是0和1,但你想,如果让你读一长串像“1101001010110101”这样的二进制数,是不是眼花缭乱,非常容易数错?16进制就像一个超级好用的“缩写工具”,它最大的妙处在于:一个16进制数字,刚好可以完美地表示4个二进制位(比特),二进制“1111”就等于16进制的“F”,这样一来,一长串二进制数立刻就能被缩短成简洁明了的16进制串,读写和检查起来都方便太多了,你在看内存地址、颜色代码(比如网页上的#FF9900)、或者处理网络数据包时,看到的那些带字母的数字,基本都是16进制。

核心问题来了:当我们看到一个16进制数,2A3F”,如何在脑子里快速把它转换成我们理解的10进制数呢?这里有几个层次的方法,从基础到高效,你可以一步步掌握。

第一层:理解原理,打好地基

这个方法虽然看起来慢,但它是所有技巧的基础,必须懂,16进制的每一位都有不同的“权重”,这个权重是16的幂次方,和我们熟悉的10进制一样,10进制是“个、十、百、千”(也就是10^0, 10^1, 10^2, 10^3...),16进制则是“个、十六、二百五十六、四千零九十六”(也就是16^0, 16^1, 16^2, 16^3...)。

转换时,从右往左,把每一位的数字乘上它对应的权重,然后把所有结果加起来,这里关键是要记住16进制用了16个符号:0-9表示0到9,A-F(或a-f)表示10到15。

举个例子,转换“2A3F”:

第二层:熟能生巧,快速心算

当你理解了原理后,可以通过练习一些常用组合来加快速度,不需要记太大的数,主要是熟悉前几位权重和字母对应的值。

第三层:编程中的“作弊”技巧——让工具帮你算

这才是“高效指南”的精髓!在编程时,你根本不需要每次都手动计算,你的开发环境提供了最强大的工具。

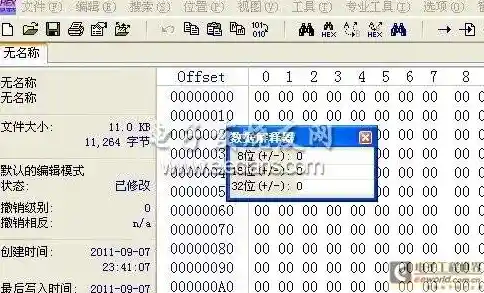

程序员计算器:无论是Windows、macOS还是Linux,都可以找到程序员模式的计算器,你只需输入16进制数,然后点一下“DEC”(十进制)按钮,结果瞬间就出来了,这是最直接、最不容易出错的方法。

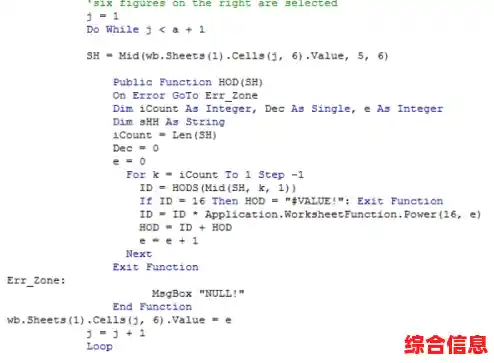

编程语言的内置功能:所有主流编程语言都内置了数制转换的函数,这才是真正的“高效”,你只需要写一行代码,转换工作就交给计算机去完成。

hex_str = "2A3F",直接用 int(hex_str, 16) 就能得到十进制整数。print(int("2A3F", 16)) 会直接输出 10815。parseInt("2A3F", 16),得到的结果就是十进制的10815。strtol 函数或 Integer.parseInt 方法,并指定基数为16。在编程实践中的应用场景

知道了怎么转换,更要明白何时何地会用到它,这样学习才有意义。

学习16进制到10进制的转换,核心目标不是为了成为人肉计算器,而是为了建立一种数制间的直觉,你需要扎实理解其背后的原理,这样在阅读代码、分析数据时,即使不进行精确计算,也能大致估摸出数值的大小和含义,而在实际编程工作中,则要善于利用工具和语言特性,把繁琐的计算交给计算机,让自己专注于更重要的逻辑设计,这种“理解原理”加上“善用工具”的组合,才是真正的高效之道。