在我们日常使用手机、电脑,甚至是观看网络视频、玩游戏的时候,有一个看不见的“帮手”在背后默默发力,让一切变得无比流畅,这个帮手就是硬件加速技术,它不像软件那样需要一步步地通过中央处理器来思考,而是通过专门的硬件电路,为特定的任务开辟出一条“高速公路”,让数据处理速度得到质的飞跃,可以说,硬件加速是解锁高效计算新境界的一条非常关键的道路。

要理解硬件加速为什么这么重要,我们可以先想象一个场景,一个才华横溢的大学教授,他知识渊博,能解答数学、物理、文学、历史等各种问题,如果你问他一个复杂的数学公式,他需要翻阅资料、进行演算,这需要时间,但如果有一个专门为解决这类数学公式而设计的计算器,那么按下几个按钮,答案瞬间就出来了,在这个比喻里,教授就像是电脑的中央处理器,它非常强大,什么都能做,但面对海量、重复且专业的计算任务时,可能会力不从心,而那个专门的计算器,就是硬件加速单元,它只为一件事情而生,所以能把这件事做到极致的高效和节能。

我们身边到处都是硬件加速的例子,最经典的莫过于我们电脑里的显卡,也就是GPU,最初,GPU的任务就是画图,负责把一个个像素点显示在屏幕上,玩游戏时,场景里有成千上万个多边形需要实时计算光影、纹理,如果这些都让CPU来做,电脑会卡得动弹不得,GPU就是为这种大规模并行计算而生的,它有成千上万个小核心,可以同时处理大量简单的计算任务,所以才能让我们享受到逼真流畅的游戏画面,后来,人们发现GPU的这种能力不仅限于画图,在人工智能、科学计算等需要海量数据并行的领域同样大放异彩。

再看视频播放,当我们在线看一部高清电影时,视频文件是被压缩过的,需要实时解压缩才能播放,这个解压缩的过程如果交给CPU,会占用大量的资源,电脑可能会发烫,风扇狂转,同时做其他事情就会变卡,而现在的手机和电脑里,基本都有一颗专门的“视频解码器”,这颗芯片的唯一工作,就是高效地解码视频流,因为它专精于此,所以能以极低的功耗流畅播放4K甚至8K视频,让CPU腾出手来处理你的其他操作。

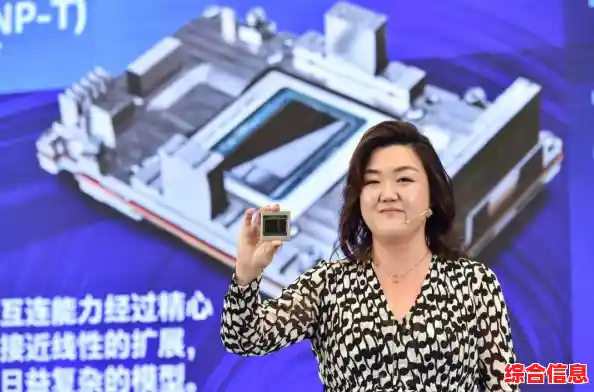

近年来非常火热的人工智能,更是硬件加速技术大展身手的舞台,AI模型的训练和推理,本质上都是庞大的矩阵运算,传统的CPU架构并不擅长这种计算,更专业的AI加速芯片应运而生,比如NPU,这些芯片的设计从底层就是为AI算法优化的,它们在执行图像识别、语音助手、智能推荐等任务时,速度比CPU快几个数量级,功耗却低得多,你手机拍照时的人像虚化、夜景增强,背后往往就是NPU在瞬间完成计算。

甚至在我们习以为常的存储和网络领域,硬件加速也在发挥作用,一些高端固态硬盘自带加密功能,数据写入时直接由硬盘上的电路完成加密,速度快且不消耗CPU,网络控制器也能通过硬件加速来快速处理数据包,降低网络延迟,让在线游戏和视频会议更顺畅。

为什么硬件加速会成为未来的关键路径呢?答案在于我们面对的数据洪流,我们正进入一个由数据驱动的时代,高清视频、虚拟现实、物联网、自动驾驶、大型人工智能模型……这些应用产生的数据量是前所未有的,如果所有这些计算压力都指望通用的CPU来承担,那么无论CPU变得多快,都会遇到功耗和效率的瓶颈,这就好比试图用一辆万能工程车去应对所有运输任务,它既能拉货也能载人,但肯定不如专门的集装箱卡车拉货效率高,也不如舒适的客车载人体验好。

未来的计算架构,必然是一个“团队协作”的模式,CPU作为大脑,负责复杂的逻辑判断和任务调度;而各种各样的硬件加速单元,就像是一个个身怀绝技的专家,在GPU、NPU、DSP等岗位上,高效处理自己最擅长的任务,这种分工协作,才能最大限度地提升整体计算效率,降低能耗,让我们能够应对未来更复杂、更智能的应用需求。

硬件加速技术并不是一个遥远的概念,它已经深深融入我们数字生活的方方面面,它通过“专业分工”的理念,将特定的计算任务从通用的处理器中卸载出来,交由更专业的硬件去执行,从而实现了效率的倍增和能耗的降低,随着我们对计算能力的需求永无止境地增长,继续挖掘和优化硬件加速的潜力,无疑是通向更高计算效能境界的必经之路,它让更快、更智能、更节能的数字体验成为可能。